Как убрать дублирующиеся страницы на сайте

Бывают случаи, когда поисковые роботы индексируют собственные запросы на страницах вашего сайта или установленные на страницах сайта UTM-метки. Робот определяет их как разные страницы с одинаковым контентом и присылает уведомление:

Примечание

Некоторые страницы вашего сайта содержат одинаковый контент. Из-за их обхода информация о важных страницах может медленнее передаваться в поисковую базу, что может влиять на состояние сайта в поиске.

Ранее мы сделали системный файл robots.txt доступным для редактирования, и сейчас вы можете самостоятельно внести директиву запрета индексации подобных GET-запросов/UTM-меток.

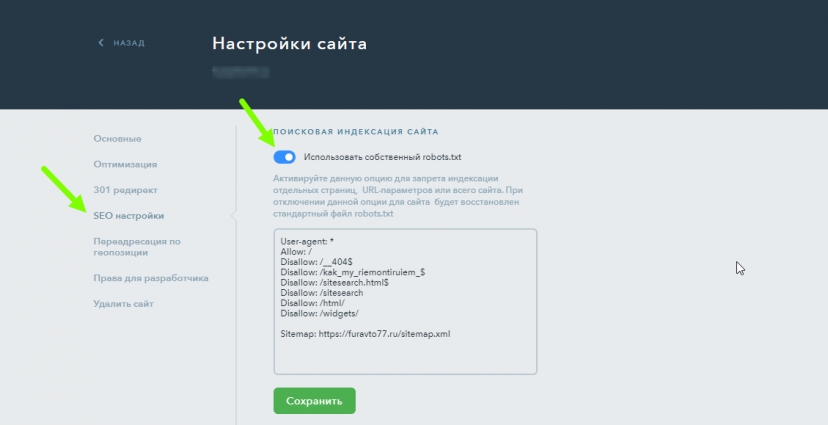

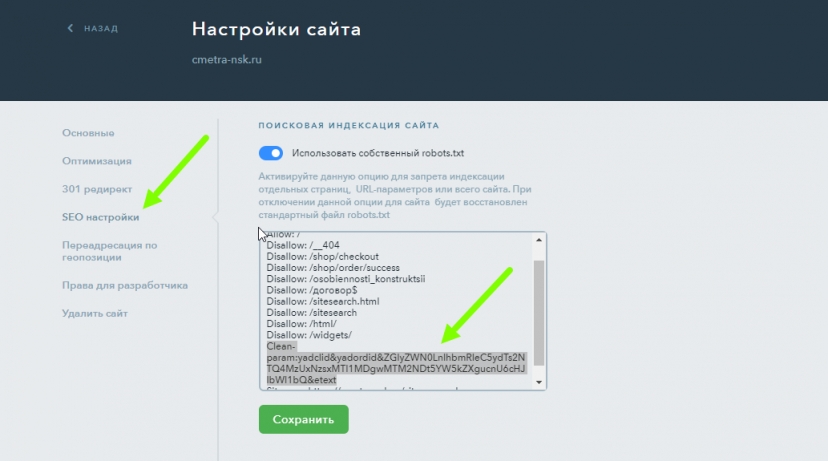

Сначала вам нужно войти в SEO-настройки сайта в панели управления и включить опцию «Использовать собственный robots.txt»:

Создание директивы Clean-param

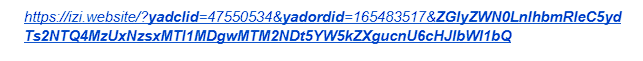

Затем нужно составить директиву "Clean-param" и перечислить названия повторяющихся параметров. Параметр на странице может быть один, а может быть и несколько. Чтобы найти названия всех параметров, посмотрите на адрес дублирующих страниц. Название параметра всегда начинается после знака "?" и заканчивается перед знаком "=" или знаком "&". К примеру на странице:

Параметрами будут являться "yadclid", "yadordid" и "ZGlyZ...".

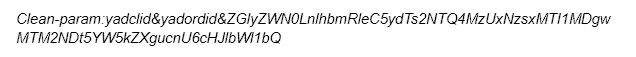

Составляем директиву "Clean-param:", после двоеточия перечисляем повторяющиеся на странице названия параметров, разделяя их знаком "&". Получится следующая запись:

Примечание

Данные выше используются в качестве примера. В вашем запросе данные могут отличаться.

Проверка созданной директивы

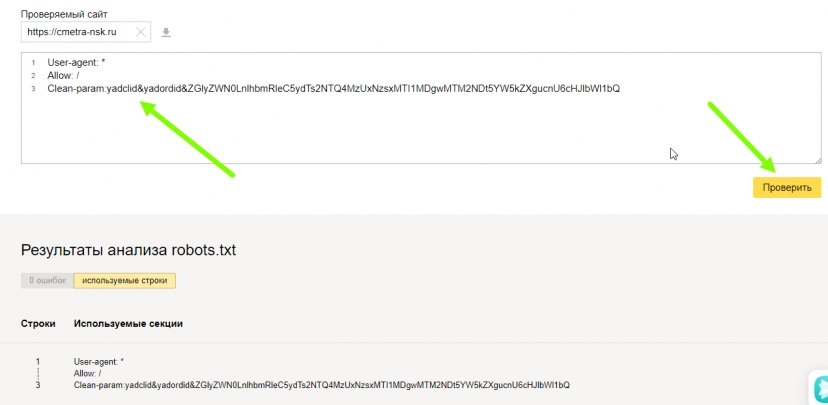

Перед тем, как устанавливать запись в robots, рекомендуем проверить ее в Яндекс Вебмастере. Для этого нужно перейти на страницу https://webmaster.yandex.ru/tools/robotstxt/. Укажите адрес сайта, затем нажмите значок «Загрузить». Вебмастер загрузит записи файла robots вашего сайта. Добавьте отдельной строкой составленную директиву Clean-param и нажмите «Проверить»:

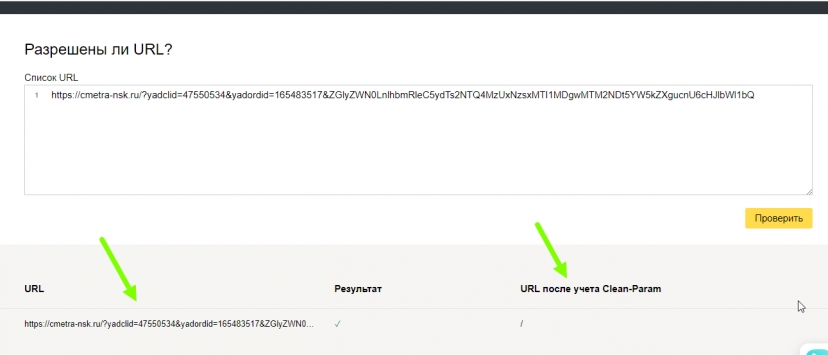

Затем внизу страницы в окне «Разрешены ли URL?» укажите полные адреса дублирующихся страниц, каждую с новой строки, если их несколько, и нажмите «Проверить»:

Если директива составлена верно, в результате ее применения URL вашего сайта не будет содержать параметры и метки. Робот Яндекса, используя эту директиву, не будет многократно перезагружать дублирующуюся информацию.

Добавление директивы в robots на сайте

Теперь, когда вы составили и проверили директиву, эту строчку нужно добавить в robots, сохранить и переопубликовать сайт:

По такому принципу вы можете удалить текущие и будущие дублирующиеся страницы на вашем сайте, если они будут появляться снова.

Примечание

Подробная инструкция по редактированию файла robots и использованию директивы Clean-param есть в справочнике Яндекса по ссылке: https://yandex.ru/support/webmaster/robot-workings/clean-param.html.

Попробуйте прямо сейчас!

Создать сайт